Nvidia ha lanzado una solución enfocada al desarrollo de modelos de Inteligencia Artificial (IA) y que busca garantizar que las respuestas que ofrezcan sean correctas, específicas, seguras y legítimas.

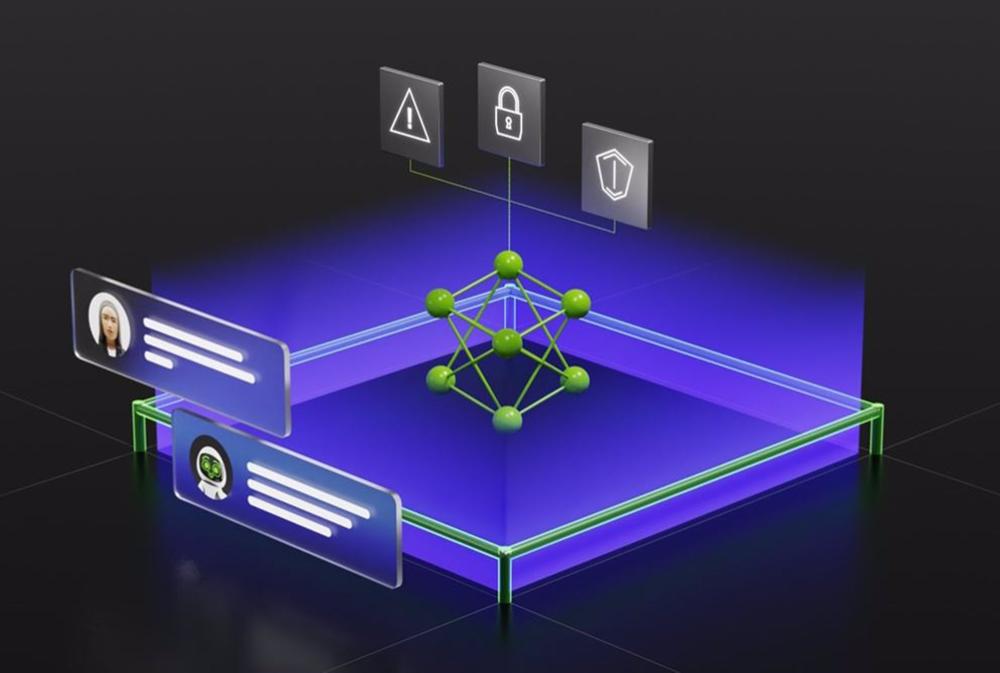

Se trata de un ’software’ de código abierto que recibe el nombre de NeMo Guardrails y que integra ’’el código, los ejemplos y la documentación que las empresas necesitan para añadir seguridad a las aplicaciones de IA que generan texto’’, según ha señalado la compañía en un escrito.

Nvidia ha explicado que esta solución, enfocada a garantizar que las aplicaciones inteligentes impulsadas por modelos de lenguaje extenso (LLM) sean ’’precisas, apropiadas, específicas y seguras’’, llega en un momento en que muchas industrias están adoptando la IA en sus procesos.

Debido a que ’’la seguridad en la IA generativa es una preocupación de toda la industria’’, NeMo Guardrails está diseñado para que funcione con todos los LLM, entre los que se encuentran ChatGPT, desarrollado por OpeanAI; así como para todas las herramientas que usan los desarrolladores de aplicaciones empresariales.

Concretamente, este ’software’ permite a los desarrolladores establecer tres tipos de límites. Por un lado, se encargan de evitar que las aplicaciones se desvíen a temas no deseados, que sus aplicaciones respondan con información precisa y adecuada -filtrando en todo caso lenguaje no deseado y las noticias falsas o erróneas- y, por último, que las aplicaciones solo se puedan conectar con aplicaciones externas de terceros seguras.

NeMo Guardrails ya está disponible como código fuente abierto en GitHub y los desarrolladores pueden obtenerlo también a través de Nvidia AI Enterprise. Asimismo, esta solución está disponible como servicio, ya que es parte de Nvidia AI Foundations, familia de servicios en la nube para organizaciones que deseen crear y ejecutar modelos de IA generativos personalizados.

Fuente: (EUROPA PRESS)